Benchmark Tensorflow™ Inception v3

LeaderGPU® è un nuovo e ambizioso operatore del mercato del GPU computing intenzionato a cambiare le regole del gioco. Secondo i risultati dei test, la velocità di calcolo per il modello Inception v3 su LeaderGPU® è superiore di 3 volte rispetto a Google Cloud e di 2,9 volte rispetto a AWS (dati relativi a un esempio con 8x GTX 1080). Su LeaderGPU®, il costo del leasing della GPU parte da 0,02 euro al minuto, una cifra inferiore di oltre 4 volte rispetto a Google Cloud e di oltre 5 volte rispetto a AWS (dati aggiornati al 7 luglio).

In questo articolo vengono illustrati i risultati dei test per il modello Inception v3 nei servizi offerti da LeaderGPU®, AWS e Google Cloud. Consultando l'articolo, potrai capire i motivi per cui LeaderGPU® è l'offerta più interessante tra le opzioni considerate.

Tutti i test sono stati svolti utilizzando Python 3.5 e Tensorflow-gpu 1.2 su dispositivi con GTX 1080, GTX 1080 TI e Tesla® P 100, con sistema operativo CentOS 7 installato e libreria CUDA® 8.0.

Per i test sono stati utilizzanti i seguenti comandi:

# git clone https://github.com/tensorflow/benchmarks.git# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2(Numero di schede sul server) --model inception3 --batch_size 32 (64, 128)Istanze GTX 1080

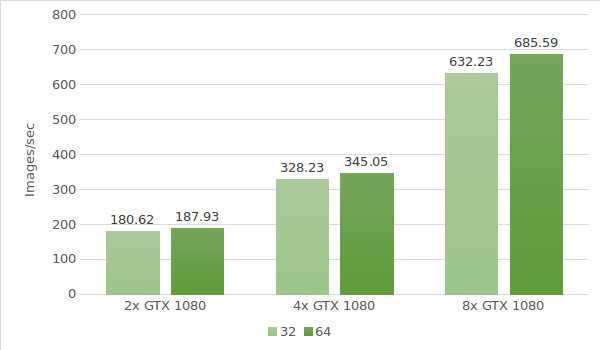

Per il primo test abbiamo utilizzato le istanze con GTX 1080. Seguono i dati dell'ambiente di test (con batch di dimensioni 32 e 64):

- Tipi di istanza:ltbv17, ltbv13, ltbv16

- GPU: 2x GTX 1080, 4x GTX 1080, 8x GTX 1080

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash:b1e174e

- Benchmark GitHub hash:9165a70

- Comando:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model inception3 –batch size 32 (optional 64) - Modello:Inception v3

- Data del test:giugno 2017

I risultati del test sono indicati nel seguente grafico:

Istanze GTX 1080TI

Abbiamo quindi testato le istanze con GTX 1080 Ti. Seguono i dati dell'ambiente di test (con batch di dimensioni 32 e 64):

- Tipi di istanza:ltbv21, ltbv18

- GPU: 2x GTX 1080TI, 4x GTX 1080TI

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash:b1e174e

- Benchmark GitHub hash:9165a70

- Comando:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 (4) --model inception3 --batch_size 32 (optional 64, 128) - Modello:Inception v3

- Data del test:giugno 2017

I risultati del test sono indicati nel seguente grafico:

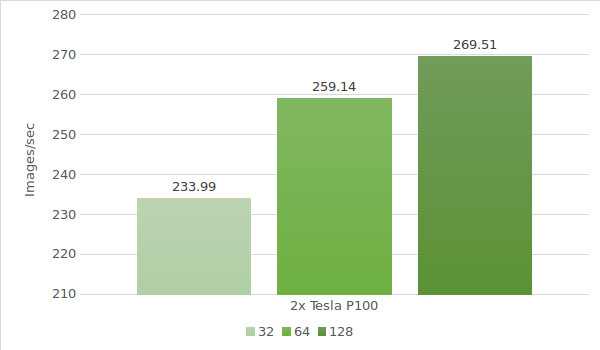

Istanza Tesla® P100

Per concludere, abbiamo testato il modello con Tesla® P100. Seguono i dati dell'ambiente di test (con batch di dimensioni 32, 64 e 128):

- Tipi di istanza:ltbv20

- GPU:GPU: 2x NVIDIA® Tesla® P100

- OS:CentOS 7

- CUDA / cuDNN:8.0 / 5.1

- TensorFlow GitHub hash:b1e174e

- Benchmark GitHub hash:9165a70

- Comando:

# python3.5 benchmarks/scripts/tf_cnn_benchmarks/tf_cnn_benchmarks.py --num_gpus=2 --model inception3 –batch size 32 (optional 64, 128) - Modello:Inception v3

- Data del test:giugno 2017

I risultati del test sono indicati nel seguente grafico:

La seguente tabella mostra i risultati dei test di Inception v3 su Google Cloud e AWS (con batch di dimensioni 64):

| GPU | Google cloud | AWS |

|---|---|---|

| 1x Tesla K80 | 30.5 | 30.8 |

| 2x Tesla K80 | 57.8 | 58.7 |

| 4x Tesla K80 | 116 | 117 |

| 8x Tesla K80 | 227 | 230 |

*I dati per la tabella sono stati recuperati dalle seguenti fonti:

https://www.tensorflow.org/lite/performance/measurement#details_for_google_compute_engine_nvidia_tesla_k80

https://www.tensorflow.org/lite/performance/measurement#details_for_amazon_ec2_nvidia_tesla_k80

Passiamo ora al calcolo dei costi e dei tempi di elaborazione di 1.000.000 di immagini su dispositivi con LeaderGPU®, AWS e Google. I dati sono relativi a un batch di dimensione 64 per tutti i dispositivi.

| GPU | Numero di immagini | Tempo | Costo al minuto | Costo totale |

|---|---|---|---|---|

| 2x GTX 1080 | 1000000 | 88m 41sec | €0.03 | €2.66 |

| 4x GTX 1080 | 1000000 | 48m 18sec | €0.02 | €0.97 |

| 8x GTX 1080 | 1000000 | 24m 18sec | €0.11 | €2.67 |

| 4x GTX 1080TI | 1000000 | 33m 47sec | €0.02 | €0.68 |

| 2х Tesla P100 | 1000000 | 64m 18sec | €0.02 | €1.29 |

| 8x Tesla K80 Google cloud | 1000000 | 73m 25sec | €0.0825** | €6.05 |

| 8x Tesla K80 AWS | 1000000 | 72m 27sec | €0.107 | €7.75 |

*Il servizio Google Cloud non offre piani di pagamento al minuto. Il costo al minuto è stato calcolato sulla base del prezzo orario ($5.645).

Come possiamo osservare nella tabella, la velocità di elaborazione delle immagini con il modello Inception v3 è la più elevata su 8x GTX 1080 con LeaderGPU®. Inoltre:

il costo proposto da LeaderGPU® parte da €1,77, inferiore di circa 3,42 volte rispetto alle istanze di 8x Tesla® K80 con Google Cloud e di circa 4,38 volte rispetto alle istanze di 8x Tesla® K80 con AWS;

la velocità di elaborazione è di 24 minuti e 18 secondi, superiore di 3,03 volte rispetto alle istanze di 8x Tesla® K80 con Google Cloud e di 2,99 volte rispetto alle istanze di 8x Tesla® K80 con AWS.

I risultati dei test non lasciano alcun dubbio: LeaderGPU® è un leader comprovato nel campo del GPU computing, in grado di offrire soluzioni senza rivali a prezzi ragionevoli. Approfitta subito della straordinaria convenienza offerta da LeaderGPU® nel campo del GPU computing!