Modelli di Stable Diffusion: personalizzazione e opzioni

La messa a punto è un modo eccellente per migliorare ogni auto o gadget. Anche le reti neurali generative possono essere messe a punto. Oggi non vogliamo approfondire la struttura della Diffusione Stabile, ma ci proponiamo di ottenere risultati migliori rispetto a una configurazione standard.

Ci sono due modi semplici per farlo: installare modelli personalizzati e utilizzare le opzioni di ottimizzazione standard. In questo articolo scopriremo come installare nuovi modelli in Stable Diffusion e quali opzioni ci permettono di utilizzare l'hardware in modo più efficace.

Se si vogliono condividere immagini divertenti di gatti carini o di cibo dall'aspetto fantastico, di solito le si pubblica su Instagram. Se si sviluppano applicazioni e si vuole rendere il codice disponibile a tutti, lo si pubblica su GitHub. Ma se addestrate un modello grafico di intelligenza artificiale e volete condividerlo, dovreste prestare attenzione a CivitAI. Si tratta di un'enorme piattaforma per condividere conoscenze e risultati con i membri della comunità.

Prima di iniziare il download, è necessario cambiare la directory di lavoro. Tutti i modelli di intelligenza artificiale in Stable Diffusion sono collocati nella directory "models": prima di iniziare il download, è necessario cambiare la directory di lavoro. Tutti i modelli di intelligenza artificiale in Stable Diffusion si trovano nella directory "models":

cd stable-diffusion-webui/models/Stable-diffusionVerifichiamo quali sono i modelli forniti di default:

ls -a'Put Stable Diffusion checkpoints here.txt' v1-5-pruned-emaonly.safetensors

C'è solo un modello con il nome "v1-5-pruned-emaonly" e l'estensione "safetensors". Questo modello è un buon punto di partenza, ma ci sono altri cinque modelli interessanti. Scarichiamoli e confrontiamoli con il modello standard.

Modelli a diffusione stabile

Per mostrare visivamente la differenza tra i due modelli, abbiamo creato dei semplici prompt:

princess, magic, fairy tales, portrait, 85mm, colorful

Per molti modelli, la rappresentazione accurata della geometria e dei tratti del viso può rappresentare una sfida significativa. Per ovviare a questo problema, si possono aggiungere suggerimenti negativi per garantire la generazione di immagini prive di queste caratteristiche:

poorly rendered face, poorly drawn face, poor facial details, poorly drawn hands, poorly rendered hands, low resolution, bad composition, mutated body parts, blurry image, disfigured, oversaturated, bad anatomy, deformed body features

Impostare il valore massimo dei passi di campionamento (150) per ottenere maggiori dettagli nel risultato.

Modello standard

Il modello standard si comporta bene in questi compiti. Tuttavia, alcuni dettagli non sono del tutto accurati. Ad esempio, c'è un problema con gli occhi: sono chiaramente sproporzionati:

Anche il diadema è storto e asimmetrico. Il resto dei dettagli è ben eseguito e corrisponde alle indicazioni fornite. Lo sfondo è sfocato perché abbiamo impostato la richiesta "85 mm". Questa è una lunghezza focale molto usata per i ritratti nella fotografia professionale.

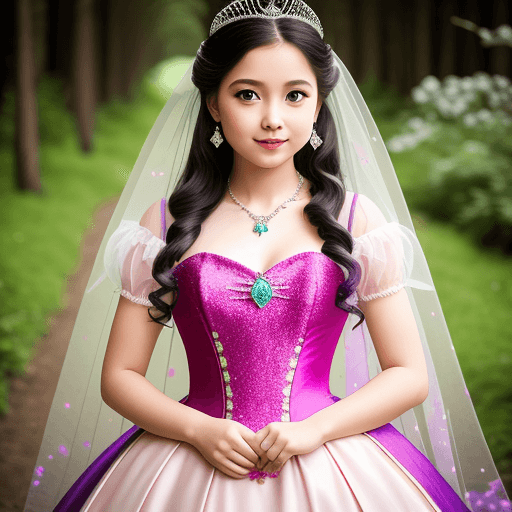

Visione realistica

Questo modello è ottimo per i ritratti. L'immagine appare come se fosse stata scattata con un obiettivo di qualità con la lunghezza focale specificata. Le proporzioni del viso e del corpo sono precise, l'abito si adatta perfettamente e il diadema sulla testa ha un aspetto esteticamente gradevole:

A proposito, l'autore raccomanda di utilizzare il seguente modello per i suggerimenti negativi:

deformed iris, deformed pupils, semi-realistic, cgi, 3d, render, sketch, cartoon, drawing, anime:1.4), text, close up, cropped, out of frame, worst quality, low quality, jpeg artifacts, ugly, duplicate, morbid, mutilated, extra fingers, mutated hands, poorly drawn hands, poorly drawn face, mutation, deformed, blurry, dehydrated, bad anatomy, bad proportions, extra limbs, cloned face, disfigured, gross proportions, malformed limbs, missing arms, missing legs, extra arms, extra legs, fused fingers, too many fingers, long neck

Ma anche con i nostri suggerimenti piuttosto semplici, il risultato è eccellente.

Scaricate il modello qui: Visione realisticaDeliberato

Un altro modello sorprendente per questi scopi. Anche qui i dettagli sono ben elaborati, ma fate attenzione e controllate il numero di dita. Questo è un problema molto comune con le reti neurali: spesso possono disegnare dita in più o addirittura interi arti.

La creazione di linee visive è una delle tecniche cinematografiche preferite. Così, anche questo modello ha scelto di disegnare una persona sullo sfondo di un sentiero boschivo.

Scaricate il modello qui: Deliberato

Viaggio aperto

Tra le reti neurali generative, Midjourney (MJ) ha ricevuto particolare attenzione. MJ è stato un pioniere in questo campo e viene spesso additato come esempio per gli altri. Le immagini che crea hanno uno stile unico. OpenJourney si ispira allo stile di MJ ed è una Diffusione Stabile opportunamente ottimizzata.

Genera immagini che sembrano un cartone animato. Sono vibranti e luminose. Per ottenere risultati migliori, aggiungete il prompt dello stile mdjrny-v4.

Scaricate il modello qui: OpenJourney

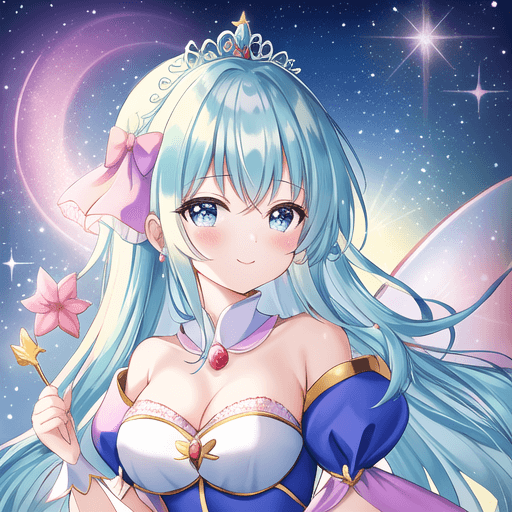

Qualsiasi cosa

Questo modello crea immagini simili a quelle di un artista manga professionista (una persona che disegna fumetti). Così, abbiamo una principessa in stile anime.

Questo modello viene addestrato su immagini con una risoluzione di 768x768. È possibile impostare questa risoluzione per ottenere risultati migliori rispetto allo standard 512x512.

Scaricate il modello qui: Qualsiasi cosa

Azienda Memphis

Questo stile di immagini ha acquisito una popolarità selvaggia nei primi anni 2020 ed è stato ampiamente utilizzato come stile aziendale in diverse aziende high-tech. Nonostante le critiche, si trova spesso nelle presentazioni e nei siti web.

La principessa si è rivelata minimalista, ma piuttosto bella. Particolarmente divertenti sono stati i dettagli che la modella ha inserito sullo sfondo.

Scaricate il modello qui: Memphis aziendale

Opzioni di diffusione stabili

La diffusione stabile consuma molte risorse, per cui sono state sviluppate molte opzioni. La più popolare è --xformers. Questa opzione abilita due meccanismi di ottimizzazione. Il primo riduce il consumo di memoria e il secondo viene utilizzato per aumentare la velocità.

Se si prova ad aggiungere --xformers senza ulteriori passaggi, si otterrà un errore che dice che i pacchetti(torch e torchvision) sono compilati per versioni diverse di CUDA®. Per risolvere questo problema, è necessario entrare nell'ambiente virtuale Python (venv) utilizzato per Stable Diffusion. Successivamente, installare i pacchetti per la versione di CUDA® desiderata (v1.18).

Per prima cosa dobbiamo aggiornare la cache dei pacchetti apt e installare il programma di installazione dei pacchetti per Python (pip). Il passo successivo è attivare Python venv con lo script activate:

source stable-diffusion-webui/venv/bin/activateDopo di ciò, il prompt della riga di comando cambia in (venv) username@hostname:~$ Installiamo i pacchetti torch e torchvision con CUDA® 11.8:

pip install torch==2.0.0+cu118 torchvision==0.15.1+cu118 --index-url https://download.pytorch.org/whl/cu118Questo processo potrebbe richiedere diversi minuti perché i pacchetti sono piuttosto grandi. Avrete giusto il tempo di versarvi un caffè. Infine, è possibile disattivare l'ambiente virtuale e avviare Stable Diffusion con l'opzione --xformers (sostituire [user] e [password] con i propri valori):

deactivate./webui --xformers --listen --gradio-auth [user]:[password]L'alternativa più veloce a --xformers è --opt-sdp-no-mem-attention, che consuma più memoria ma funziona un po' più velocemente. È possibile utilizzare questa opzione senza ulteriori passaggi.

Conclusione

Oggi abbiamo esaminato le capacità di Stable Diffusion in combinazione con altri modelli aggiunti e opzioni di ottimizzazione. Ricordiamo che aumentando o diminuendo il numero di passaggi di campionamento, è possibile regolare il livello di dettaglio dell'immagine finale.

Naturalmente, questa è solo una piccola parte di ciò che si può fare con una rete neurale generativa di questo tipo. Quindi ordinate subito un server GPU e iniziate a sperimentare. Molte altre scoperte e opportunità vi attendono. Le schede video potenti e ad alta velocità vi aiuteranno a risparmiare tempo e a generare immagini fantastiche.

Vedi anche:

Aggiornato: 04.01.2026

Pubblicato: 25.11.2024